Suivi d'objets dans l'espace 3D : méthodes et applications

Nous vous rappelons que, afin de garantir l'accès de tous les inscrits aux salles de réunion, l'inscription aux réunions est gratuite mais obligatoire.

Inscriptions closes à cette réunion.

Inscriptions

12 personnes membres du GdR ISIS, et 0 personnes non membres du GdR, sont inscrits à cette réunion.

Capacité de la salle : personnes.

Annonce

Le suivi d'objet dans l'espace (3D) est un sujet dont l'importance a émergé avec la robotique autonome, la robotique humanoïde et avec... le vieillissement de la population dont la vue et l'orientation spatiale diminuent (maladie d'Alzheimer).

Cette journée, la première de notre action « Navigation et perception de l'environnement 3D » de l'axe 2 « Vision, géométrie 3D, mouvement » du thème B « Image et Vision » du GDR ISIS, vise donc à faire un état de l'art sur les méthodes robustes existantes de suivi 3D temps réel d'objets, tant dans l'environnement intérieur qu'extérieur, scènes statiques et dynamiques, connues ou inconnues a priori.

Cela permettra de rapprocher deux communautés, la vision et la robotique, et d'identifier les problématiques et les approches méthodologiques communes, tant théoriques qu'applicatives, pouvant permettre de préparer de propositions nationales et européennes.

Aussi, nous invitons des communications sur les approches :

- de suivi visuel (de préférence 3D) (de caractéristiques, de régions, de mesures de vitesse) ou fondé sur des modèles (classification de Berkeley) ;

- basées sur fusion de données multisensorielles ;

- s'appuyant sur des modèles neuro-cognitifs.

Ces approches peuvent viser une implantation matérielle portable, et peuvent être définies dans des cadres applicatifs variés tels qu'un robot terrestre/aérien/humanoïde ou l'homme.

Les résumés des propositions (1/2 page environ) devront parvenir à Edwige.Pissaloux (a) upmc.fr, daniel.duclos (a) sagem.com; frederic.devernay (a) inria.alpes.fr pour le 7 janvier 2011.

Programme

9h45 - 10h : Accueil

Session du matin

- 10h - 10h30 - Positionnement et Suivi 3-D pour le Guidage par Vision; Contributions et applications à la robotique médicale, Christophe Doignon (Ecole Nationale Supérieure de Physique de Strasbourg).

- 10h30 - 11h - Suivi d'objet de géométrie linéaire en imagerie ultrasonore 3D, Hervé Liebgott (Creatis-LRMN).

- 11h - 11h30 - Localisation 3D en environnement intérieur par caméra portée pour la détection d'événements liés aux activités, Hazem Wannous (LIFL - Université de Lille 1 / Telecom Lille 1), Vladislavs Dovgalecs (IMS - Université de Bordeaux 1), Rémi Mégret (IMS - Université de Bordeaux 1).

- 11h30 - 12h - Suivi multi-objets basé modèle par vidéo : application au contrôle de traitements par radiothérapie, Miguel Portela Sotelo (LIRIS - Equipe SAARA)

12h - 14h - Pause déjeuner

Session de l'après-midi

- 14h - 14h30 - 3D face tracking including non verbal expressions, André Gagalowicz (INRIA).

- 14h30 - 15h - An Augmented Spherical Visual Sensor for Large Scale 3D SLAM, Andrew Comport (Laboratoire I3S-CNRS), Maxime Meilland (INRIA Sophia Antipolis), Patrick Rives (INRIA Sophia Antipolis)

- 15h - 15h30 - Suivi et estimation de pose d'objet 3D par stéréovision omnidirectionnelle, Guillaume Caron (IRISA/INRIA &MIS - Université de Picardie), Eric Marchand (Université de Rennes 1 & IRISA/INRIA), El Mustapha Mouaddib (IRISA/INRIA & MIS, Université de Picardie).

- 15h30 - 16h - Localisation 3D multi-capteurs pour les applications de Réalité Augmentée en Milieu Extérieur, Fakhreddine Ababsa (IBISC, Université d'Evry-Val-d'Essonne).

- 16h - 16h30 : discussion avec les participants

16h30 - Fin de la journée.

Résumés des contributions

Positionnement et Suivi 3-D pour le Guidage par Vision; Contributions et applications à la robotique médicale

Christophe Doignon, Ecole Nationale Supérieure de Physique de Strasbourg

Les progrès de ces dix dernières années réalisés sur les techniques du suivi visuel, de la commande et sur les technologies des calculateurs dédiés, ont permis d'étendre largement le spectre des applications du suivi 3-D d'objet. C'est majoritairement par des méthodologies issues de la robotique, mais aussi du filtrage et de l'apprentissage, que l'on a vu émerger de nouvelles techniques mises en oeuvre pour appréhender des environnements de moins en moins structurés et variables. Ceci peut s'expliquer en partie par le fait que le suivi 3-D, au contraire du suivi visuel, nécessite de se référer à des apparences ET à des paramètres géométriques ou cinématiques définis dans un référentiel lié à l'objet d'intérêt. Ainsi les grandeurs géométriques mises en jeu font appels aux méthodes connues du recalage alors que les grandeurs cinématiques établissent une passerelle entre les variations apparentes dans les images et les mouvements correspondant à des déplacements euclidiens. Finalement, les deux catégories sont largement considérées dans la communauté des asservissements visuels, historiquement relevant du domaine de la robotique.

Cette présentation, qui aura pour cadre applicatif celui de l'assistance informatique et robotique aux gestes médicaux et chirurgicaux, va s'attacher à décrire l'importance des techniques de modélisation pour l'établissement d'une commande réelle ou virtuelle de robots. En effet, d'une part il existe de fortes connexions entre les algorithmes d'optimisation sollicités pour réaliser un recalage rigide et la commande dite basée position, et d'autre part les algorithmes d'optimisation utilisés pour le suivi 3-D et la commande dite basée image. C'est ainsi que les travaux de recherche sur la commande par vision qui ont démontré des propriétés de découplage et de convergence, locale ou globale, sont intéressantes pour l'efficacité du suivi 3-D, et dans ce cas, il s'agira plutôt d'une régulation visuelle.

L'exposé sera orienté plus spécifiquement vers le guidage par vision d'instruments de chirurgie, activité menée en collaboration avec d'autres acteurs de la recherche au sein du consortium Imagerie et Robotique Médicale et Chirurgicale (IRMC) de Strasbourg, en particulier avec ceux de l'Institut de Recherche contre les Cancers de l'Appareil Digestif (IRCAD).

Le problème de l'estimation de pose et plus généralement du recalage 2-D/3-D rigide sera donc abordé en empruntant plusieurs approches et différentes représentations, en fonction du contexte. Que ce soit à partir d'une approche projective des éléments imagés tels que des spots lasers ou encore par une approche d'optimisation numérique basée sur les asservissements visuels virtuels et combinant des indices visuels géométriques différents, de la modélisation par des quadriques dégénérées pour la pose d'instruments cylindriques, pour des applications telles que la commande de robot par vision laparoscopique (vision déportée) ou l'assistance informatique et robotique de la suture (vision embarquée).

Le guidage 3-D sera également décrit par l'approche du suivi pouvant être mis en oeuvre dans un environnement complexe (sous quelques hypothèses) sans passer par une étape de recalage, en tenant compte des contraintes de mouvements inhérentes à la chirurgie laparoscopique. Il permet d'effectuer, dans ce cas, un positionnement relatif d'un instrument ou d'un endoscope et offre une assistance au chirurgien, par exemple, par le suivi automatique d'une surface des organes de l'abdomen à l'aide d'un endoscope actif ou par la récupération d'instruments.

En guise de perspectives, la conception de nouveaux capteurs et l'élaboration de nouvelles méthodes en vision active seront abordées pour acquérir en temps réel des informations géométriques 3-D dans des environnements complexes (changeants, déformables, en présence d'occultations de diverses natures...).

Suivi d'objet de géométrie linéaire en imagerie ultrasonore 3D

Hervé Liebgott, Creatis-LRMN

Nos travaux concernent le suivi et le guidage d'objets de géométrie linéaire, principalement des électrodes ou des aiguilles de biopsie, grâce à l'échographie 3D. En routine clinique le suivi des biopsies est effectué grâce à l'imagerie ultrasonore classique, c'est-à-dire 2D. C'est un geste qui demande de la part du médecin une grande expertise. En effet, l'enjeu est de s'orienter dans un environnement 3D afin d'opérer le prélèvement de tissus au bon endroit et éviter ainsi un mauvais diagnostic à partir d'une image 2D. Le guidage par échographie 3D peut représenter une alternative très intéressante puisque c'est une modalité d'imagerie peu couteuse, non invasive et parce qu'elle permettrait un suivi temps réel. Malheureusement aujourd'hui l'échographie 3D est encore très peu utilisée en routine clinique. L'objectif de notre travail est de proposer aux médecins un outil d'aide au geste permettant le suivi et le guidage en temps réel par échographie 3D. En imagerie ultrasonore il existe plusieurs approches permettant de détecter une aiguille dans les images. La plupart sont basées sur deux hypothèses, i) l'aiguille apparait de manière plus échogène que le tissu environnant ; ii) l'aiguille est de géométrie linéaire. On peut regrouper les approches en 3 grandes catégories suivant qu'elles sont de type projection, analyse en composantes principales ou ajustement de modèle.

Afin de résoudre ce problème nous nous sommes donc intéressés aux méthodes d'ajustement de modèle par une procédure RANSAC supposée être robuste en présence de nombreux faux positifs. En effet les images ultrasonores font souvent apparaître d'autres structures très échogènes en plus de l'aiguille. L'approche consiste à séparer les données sensées appartenir à l'aiguille par un seuillage, puis une fonctionnelle est minimisée pour trouver le meilleur modèle grâce à une procédure RANSAC. On finit par une phase d'optimisation locale pour ajuster le modèle. L'ensemble de ce travail a été intégré dans une architecture temps réelle implantée sur un échographe de recherche. Nous avons également travaillé sur l'amélioration de la qualité des données. L'approche choisie est inspirée de l'imagerie vasculaire où on essaye d'augmenter le contraste des vaisseaux par rapport aux tissus environnants. Localement un critère de tubularité est calculé qui peut être soit utilisé pour pondérer les données avant détection soit le critère peut être utilisé directement dans la fonctionnelle minimisée. On souhaite ici présenter de manière assez générale le contexte, l'ensemble des méthodes développées ainsi que les résultats obtenus dans ce domaine depuis une dizaine d'année à CREATIS.

Localisation 3D en environnement intérieur par caméra portée pour la détection d'événements liés aux activités

Hazem Wannous, LIFL - Université de Lille 1 / Telecom Lille 1

Vladislavs Dovgalecs, IMS - Université de Bordeaux 1

Rémi Mégret, IMS - Université de Bordeaux 1

Cette présentation concerne l'application des techniques de localisation 3D au positionnement en environnement intérieur à partir d'une caméra portée. Ce travail est motivé par les objectifs applicatifs du projet ANR IMMED mené actuellement par le LaBRI, IMS, IRIT et INSERM/CHU Bordeaux, dont le but est de développer une méthodologie permettant aux médecins (experts dans le traitement de la démence) d'analyser des scènes de la vie quotidienne d'un patient sans devoir procéder à un équipement de son domicile. L'originalité réside dans l'utilisation de la capture vidéo des activités par une caméra miniature portée sur l'épaule du patient. L'IMS a mis en place un prototype adapté, qui est actuellement utilisé par les médecins dans le cadre de l'étude. Le champ de vision de la caméra est très large, permettant d'observer à la fois les activités instrumentales et le contexte environnemental. Pour une exploitation efficace des données, il est primordial de pouvoir structurer la vidéo automatiquement. L'un des indices concerne la position dans l'environnement. Les travaux présentés se fondent sur les techniques de reconstruction 3D pour fournir des modèles de l'environnement, utilisées pour servir de références à la définition de zones d'intérêt sémantique en termes d'activités instrumentales. Le suivi des marqueurs naturels de l'environnement par la mise en correspondance robuste 2D-3D avec les modèles permet d'estimer les trajectoires à 6 ddl en mouvement libre de la personne. Ces trajectoires sont ensuite analysées pour détecter les événements d'intérêts. Les résultats préliminaires sont prometteurs.

Suivi multi-objets basé modèle par vidéo : application au contrôle de traitements par radiothérapie

Miguel Portela Sotelo, LIRIS - Equipe SAARA & DOSIsoft

Nous présentons une méthode pour le suivi d'un patient et des objets dans une salle de traitement par radiothérapie. Le méthode exploite les nombreuses informations disponibles dans le dossier patient (notamment le plan de traitement issu du Système de Planification de Traitement), enrichies d'autres informations visuelles, géométriques et sémantiques. Un environnent virtuel équivalent à la salle de traitement est créé à l'aide du modèle générique que nous avons développé. Les images acquises à partir de plusieurs caméras permettent ensuite de corréler les deux environnements, virtuel et réel. La méthode sera utilisée dans un module de contrôle externe par vidéo de la salle de radiothérapie et de ses composants (humains et équipements, notamment).

3D face tracking including non verbal expressions

André Gagalowicz, INRIA

We propose a new technique for 3D face tracking in video sequences, which works without markers and once initialized, doesn't require any further interaction. A specific geometric model of the face (in a neutral position, for example) is used as input as well as a realistic hierarchical face animation model.

The algorithm includes a new method for precise face expression tracking in a video sequence.It uses this hierarchical animation system built over a morphable polyhedral 3D face model. Its low level animation mechanism is based upon MPEG-4 specification which is implemented via local point-driven mesh deformations adapted to the face geometry. The set of MPEG-4 animation parameters is in its turn controlled by a higher level system based upon facial muscles structure. This allows to perform precise tracking of complicated non verbal facial expressions as well as to produce face-to-face retargeting by transmitting the expression parameters to different faces. We finally show how to obtain an automatic semantic interpretation of the expressions from the former tracking results.

An Augmented Spherical Visual Sensor for Large Scale 3D SLAM

Andrew Comport, Laboratoire I3S-CNRS

Maxime Meilland (INRIA Sophia Antipolis)

Patrick Rives (INRIA Sophia Antipolis)

Recent research carried out jointly between the I3S and INRIA Sophia-Antipolis is based on a multi-view stereo camera sensor able to build 3D dense spherical robot-centered representations of outdoor and indoor environments. The proposed system takes advantages of six wide field of view cameras equally placed in an hexagon. A global calibration procedure is proposed to obtain consistent extrinsic parameters of all the cameras with respect to a loop closing constraint. The depth information is then extracted by a robust wide baseline dense correspondence algorithm, applied to each pair of cameras. A spherical image augmented with depth information is then generated. Using this spherical sensor mounted on a vehicle, a robust dense minimization approach permits to accurately estimates its 6dof motion. The resulting trajectory is finally used to select and improve interesting spheres in the environment for building a spherical image memory. This ego-centered representation of the environment is then used for real-time localization of a monocular or stereo camera system that is highly efficient and very robust over large scale environments. A "live" demonstration of the system shows that it is easy to quickly build dense models of the environment and then use this model to improve the efficency for 3D camera tracking.

Suivi et estimation de pose d'objet 3D par stéréovision omnidirectionnelle

Guillaume Caron, IRISA/INRIA &MIS / Université de Picardie

Eric Marchand, Université de Rennes 1 & IRISA/INRIA

El Mustapha Mouaddib, IRISA/INRIA & Laboratoire MIS, Université de Picardie

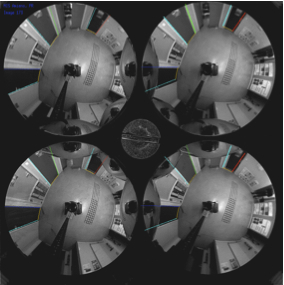

La vision en robotique a beaucoup à gagner avec les caméras catadioptriques engendrant une perception à large champ de vue ainsi qu'avec la redondance d'information apportée par la stéréovision. La fusion de ces deux caractéristiques en un seul capteur est obtenue en combinant une unique caméra et plusieurs miroirs. Nos travaux proposent un algorithme robuste de suivi d'objet 3D en utilisant les images stéréo-catadioptriques acquises par ce capteur. Le travail présenté repose sur une adaptation de l'asservissement visuel virtuel, une méthode non-linéaire de calcul de position et d'orientation. Le modèle de caméra prend en compte la projection centrale unifiée et plusieurs miroirs. En appliquant la méthode proposée au suivi d'objet ou de scène, lorsque le capteur est monté sur un robot, les résultats montrent la robustesse de la méthode aux changements d'illumination, aux erreurs de suivi et montrent qu'utiliser quatre miroirs apporte encore plus de robustesse qu'en utiliser deux.

Estimation de pose d'objet 3D par stéréovision omnidirectionnelle. Le capteur (b) acquiert en une seule image quatre points de vue de l'environnement. Cette redondance est utilisée pour estimer la position et l'orientation 3D d'un objet ou d'une scène connus à partir des images (a,c).

Localisation 3D multi-capteurs pour les applications de Réalité Augmentée en Milieu Extérieur

Fakhreddine Ababsa, IBISC - Université d'Evry-Val-d'Essonne

Ce travail de recherche s'inscrit dans le cadre du projet ANR RAXENV (2006-2009) qui s'intéresse à la problématique du recalage réel-virtuel spécifique aux environnements extérieurs. L'enjeu de ce projet est de démontrer la faisabilité d'un système de réalité augmentée en extérieur dans le domaine des sciences et techniques de l'environnement, que ce soit en termes de technologie mais aussi d'adoption par les utilisateurs finaux. Le projet Raxenv a pour but d'explorer les moyens d'offrir à un acteur en situation de travail sur le terrain le maximum des informations nécessaires à l'exécution de sa tâche (compréhension ou intervention sur un système), et ceci en position et dans l'espace avec la possibilité de faire appel à des services distants. Un des verrous scientifiques à lever est le positionnement précis en environnement naturel et le recalage sur les données existantes (milieu peu connu, sources d'information multiples, risques d'obstruction de la vue). Nous avons développé un système de localisation 3D multi-capteurs qui repose sur trois technologies différentes : caméra, GPS et centrale inertielle. Partant du principe que le recalage basé sur le suivi visuel reste le plus précis, nous avons donc subdivisé le système de localisation en deux sous-systèmes : un système principal de vision et un système d'aide à la localisation (AL) constitué par le GPS et la centrale inertielle. Le système AL prend le relais pour fournir la localisation lorsque le système de vision devient défaillant. Par ailleurs, afin de conférer au système complet le plus d'autonomie dans la gestion des défaillances du suivi, nous avons défini trois modes de fonctionnement : initialisation / réinitialisation, suivi visuel et assistance à la localisation. Le passage d'un mode à l'autre est effectué de manière transparente par rapport à l'utilisateur grâce à un automate à états finis. Nous avons utilisé l'algorithme KLT (Kanade-Lucas-Tomasi) pour réaliser un suivi visuel 2D-2D des points d'intérêt dans les images. Ce suivi permet de mettre à jour l'appariement 2D/3D entre les points images et les points du modèle 3D et ainsi d'estimer la pose courante de la caméra. Ce système de localisation a été intégré dans le démonstrateur final du projet qui a été expérimenté en situation réelle d'utilisation. Les résultats obtenus sont dans l'ensemble probants et ont donné une entière satisfaction aux utilisateurs finaux.